Su iniziativa di alcuni soci del Circolo Legambiente Lamasena, Laura Quattrociocchi affiancata da Luca Pupparo, e Giuliano Patrizi, è stato realizzato un incontro tra il coordinatore tecnico di Deafal ONG, Matteo Mancini e la società cooperativa “La Ciera dei Colli” di cui Giuliano Patrizi ne è socio. La Ciera dei Colli, che da quasi due decenni opera sul territorio di Monte San Giovanni Campano si pone tra gli obiettivi, quello di conservare e valorizzare le tradizioni olearie delle colture di ulivi principalmente della varietà autoctona “ciera”presenti, migliorando così le condizioni culturali, economiche e professionali dei soci che ne fanno parte e del territorio che li circonda. Oggetto dell’incontro è stato un corso dedicato all’Agricoltura Organica e Rigenerativa, con risvolti di applicazione pratica allo stabile della società cooperativa monticiana, luogo di incontro delle parti. Molti sono stati gli interessati che hanno partecipato al corso, provenienti da diversi comuni limitrofi alla realtà monticiana, tra cui Veroli, dalla stessa e da comuni anche distanti come Roma.

Deafal (Delegazione Europea per l‘Agricoltura Familiare di Asia, Africa e America Latina) è una ONG costituita nel 2000 ma operativa in modo informale già dal 1998, che promuove lo sviluppo rurale e ha come obiettivi:

- l’emancipazione e lo sviluppo umano, sociale ed economico dei piccoli produttori agricoli e delle categorie più vulnerabili dei Paesi del Sud e del Nord del mondo, in una logica di cooperazione Sud-Sud e Sud-Nord, oltre che Nord-Sud;

- la tutela ambientale e la salvaguardia della biodiversità nei Paesi del Sud e del Nord del mondo;

- la promozione della sicurezza e della sovranità alimentare nei Paesi del Sud e del Nord del mondo.

Per l’Associazione il miglioramento delle condizioni di vita dei produttori agricoli, l’autodeterminazione alimentare delle comunità e la tutela del territorio e dell’ambiente passano attraverso la promozione di un’agricoltura che preservi la biodiversità, rispetti i cicli naturali e riduca la dipendenza iniqua dei produttori dal mercato; in questo senso si riserva un’attenzione particolare alla diffusione delle metodiche dell’ Agricoltura Organica e Rigenerativa, in quanto perfettamente rispondenti alle caratteristiche citate.

Deafal è accreditata al Ministero degli Affari Esteri e della Cooperazione Internazionale, riconosciuta dalla Regione Lombardia, iscritta al Registro Provinciale delle Associazioni di Milano, accreditata al Comitato Cittadino per la Cooperazione Decentrata del Comune di Roma, e iscritta al Registro regionale delle associazioni della Regione Marche.

È socia di CoLomba, COoperazione LOMBArdia, e membro del tavolo Educazione alla Cittadinanza Mondiale di CoLomba Attraverso CoLomba è socia dell’Associazione ONG italiane. Inoltre è socia di Marche Solidali (Coordinamento delle Organizzazioni Marchigiane di Cooperazione e Solidarietà Internazionale) [Fonte Deafal ONG, www.deafal.org ].

A partire da questi presupposti, è stato promosso dai soci sopracitati, il corso sull’Agricoltura Organica e Rigenerativa, svoltosi presso la sede della società cooperativa “La Ciera dei Colli”, in cui è stato possibile applicare direttamente attraverso le materie prime presenti, i principi dell’Agricoltura Organica (Figura

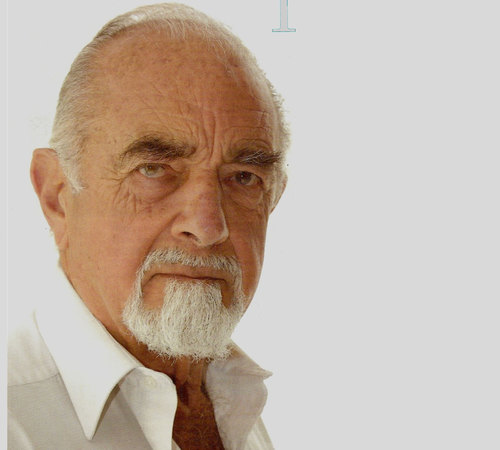

Il docente Matteo Mancini (Figura 2), laureato in Scienze Forestali e Ambientali presso la facoltà di Firenze, dopo anni di lavoro intercorsi tra America del Sud e Africa, si è specializzato in Messico in “Agricoltura Organica, disegno Keyline e Cromatografia”. Dal 2009 è Coordinatore tecnico e Consigliere di Deafal ONG, sede di Milano, per la quale si occupa di formazione e assistenza tecnica in tematiche e applicazioni di Agricoltura Organica Rigenerativa, offrendo questi servizi alle aziende agricole e privati che ne fanno richiesta.

Nella prima parte del corso è stata delucidata la composizione del terreno, facendo riferimento in particolare ad una tecnica di analisi qualitativa del suolo, la cromatografia circolare su carta, la quale permette di discriminare oggettivamente, le diverse componenti del suolo diluite in idrossido di sodio, sulla base della loro diversa affinità manifestata nei confronti del nitrato di argento impregnato su carta da filtro. Si può generalizzare l’esito di una analisi cromatografica circolare affermando che suoli poco o per niente fertili, mostrano un cromatogramma (Figura 3) in cui le diverse componenti si presentano ben stratificate, in cui sono evidenti gli accumuli di componente minerale a peso molecolare maggiore vicina al centro, segue la sostanza inorganica, quindi la sostanza organica a peso molecolare inferiore e infine, di rado esclusivamente nei terreni a maggior fertilità è possibile osservare la presenza di attività enzimatiche di origine microbiologica, le quali si separano lungo i confini della corsa circolare cromatografica terminale. Suoli molto fertili al contrario generano cromatogrammi molto più omogenei in cui è difficile distinguere le diverse componenti del suolo se non una chiara presenza della attività microbica. Un’attenta lettura e valutazione dei cromatogrammi spesso arricchisce di molte più informazioni oltre che alla semplice indicazione di fertilità dei suoli, rispecchiano infatti lo stato di salute di questi ultimi, la qualità dei composti, l’abbondanza o meno di un componente rispetto ad un altro, le trasformazioni in atto, lo stato di mineralizzazione, la struttura del suolo e molte altre. Inoltre è necessario associare all’analisi cromatografica, un’analisi chimico-fisica del suolo, in modo da ottenere un’analisi completa e dettagliata dello stato di salute del terreno.

Figura 3: Esempio di cromatogramma di un campione di terreno (Fonte: http://www.biodin.com)

Durante il corso è stato disciolto un dubbioso interrogativo su quale ruolo abbia la pratica di irrigare le coltivazioni con acqua e letame diluito, la cosiddetta “acqua grassa”, un’azione assai diffusa in passato quando la disponibilità di letame era alta e quando la concimazione minerale chimica era poco applicata. Questa pratica ha un ruolo primariamente fertilizzante e fa perdere la funzione ammendante del letame come tale; quindi l’uso “dell’acqua grassa” come fertilizzante è positivo, ma si deve essere coscienti che viene persa la capacità ammendante del letame, ovvero di strutturazione del suolo, che avrebbe se il letame fosse utilizzato come tale. Se si vuole eseguire un’operazione di concimazione organica come questa, basterebbe utilizzare del letame avicolo ad esempio (il più ricco in azoto), ma bisognerebbe diluirlo in molta acqua per evitare ustioni all’apparato radicale delle piante. In alternativa sarebbe più sicuro un altro tipo di fertilizzazione organica, come quello di diluire circa 4-5 kg di compost in 100 litri di acqua e poi procedere con l’irrigazione.

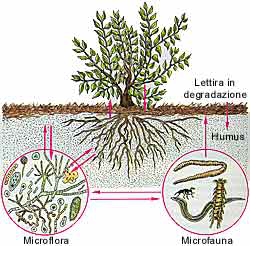

Viene definito compost il prodotto stabile e ad alta fertilità di degradazione della sostanza organica, ricco in carbonio e azoto, ad alto potere ammendante, capace dunque di cambiare significativamente la struttura del suolo. Tra le esigenze nutrizionali delle piante infatti, gioca un ruolo fondamentale la presenza della sostanza organica (SO), ossia tutta la materia morta di derivazione vivente, vegetale e animale, ricca in carbonio. L’SO diventa utile quando non entra a far parte dei processi di putrefazione, bensì quando subisce una degradazione ossidativa ad opera dei microrganismi colonizzatori del suolo. La sostanza organica quando decomposta a minerali sotto forma di ioni e sali dai microrganismi presenti nel terreno (batteri, protozoi, funghi), è resa disponibile all’assorbimento radicale e può pertanto solo in questa forma essere assunta dalle piante. In particolare al processo di degradazione della SO segue quando possibile, un processo di riorganizzazione e polimerizzazione di questa, a formare l’humus, che rappresenta esattamente

la frazione di SO decomposta e derivata dall’attività di sintesi microbica, opportunamente riorganizzata e assemblata insieme a particelle minerali, sostanze a questo stadio biodisponibili per l’assorbimento radicale. Quando un terreno è ricco di SO, riesce oltre ad essere fertile, a trattenere meglio l’acqua e quindi a diminuire la perdita di acqua dopo una pioggia o a seguito di un’irrigazione, attraverso il percolamento nel sottosuolo. L’1% di SO riesce a trattenere infatti 200’000 litri di acqua per ettaro di terreno.

Immediatamente dopo la decomposizione della materia morta derivata dagli esseri viventi vegetali e animali, vi è la fase di miscelazione meccanica delle sostanze derivate dal primo processo di decomposizione, promossa da invertebrati soprattutto lombrichi, i quali “impastano” la frazione minerale del suolo, con la frazione organica in decomposizione.

Fondamentale è questa fase di lavoro dei lombrichi in quanto preparano il terreno alla fase successiva di sintesi enzimatica in cui i batteri e soprattutto funghi completano attraverso l’azione enzimatica, la destrutturazione del materiale organico che viene completamente degradato a sostanze organiche semplici quali amminoacidi, zuccheri, vitamine, i quali possono essere sottoposti a ulteriore decomposizione e definitiva mineralizzazione (Figura 4).

Figura 4: Ciclo di decomposizione della SO, e mediazione dei lombrichi delle sostanze degradate verso la microflora[Fonte: http://www.verdeepaesaggio.it]

Le piante si nutrono di minerali derivati soprattutto dalla decomposizione della SO e probabilmente, nuove evidenze scientifiche suggeriscono che riescano ad assorbire anche molecole più complesse della SO, quali ormoni; quindi più la SO è abbondante e decomposta e più la pianta riesce a nutrirsi bene e quindi a potenziare quelle che sono la crescita dell’apparato fogliare, la fruttificazione e la resistenza ai patogeni. In uno studio sperimentale condotto proprio dal Dottor Mancini, si è visto che spesso la resistenza ai patogeni tende a migliorare quando lo stato nutrizionale della pianta è in buone condizioni, ad esempio aggiungendo al terreno un biofertilizzante. Nello studio eseguito in Toscana su colture di vite (Vitis vinifera spp.) infatti, il confronto del terreno di controllo con il terreno trattato con biofertilizzante ha mostrato un aumento della resistenza al patogeno fungineo Peronospora sp. del 50%, mentre nel terreno trattato con i classici agenti chimici fungicidi a base di rame e zolfo, ha mostrato una resistenza pari al 90%; ciò sta a significare che il più efficace nei confronti dell’infezione funginea, è stato indubbio il trattamento chimico, ma il trattamento a base di biofertilizzante non è risultato indifferente alla pianta, ha permesso altresì di proteggere dall’infezione di Peronospora sp. il 50% della popolazione di vite oggetto di studio, mostrando dunque un effetto potenziante la resistenza all’infezione dal fungo.

Alla lezione teorica è seguita la parte applicativa (Figura 5), in cui è stata spiegata l’importanza della scelta delle materie prime da selezionare, prima di tutto sulla base della disponibilità della realtà aziendale. Nel nostro caso, all’interno del frantoio della Ciera dei Colli, sono stati prelevati volumi di sansa e cippato di olivo, i quali addizionati a letame, carbone e cenere sono stati opportunamente elaborati fino ad ottenere un primo immaturo compost, al quale viste le temperature rigide della stagione invernale, è stato addizionato un inoculo di lievito liofilizzato risvegliato in acqua tiepida zuccherata.

Secondo gli studi del Dottor Mancini e colleghi, attraverso analisi chimico-fisiche e cromatografiche di diversi compost, i risultati migliori con un compost a più alto potere fertilizzante, si ottengono addizionando un 60% di sansa, un 30% di cippato e un 10% di letame. La sansa in questo caso, funge da principale fonte di carbonio, ma può essere sostituita a seconda della materia prima disponibile, per l’appunto anche da paglia o residui alimentari ad esempio. La seconda condizione affinché si generi un buon compost è la presenza di cippato, originato ovvero da potature tritate con una cippatrice; il cippato infatti oltre a rappresentare anch’esso una fonte di carbonio, funge da strutturante donando resistenza al compost. Come descritto precedentemente nella definizione di compost, è necessaria una fonte di azoto, che si può ottenere ad esempio dal letame di animali da allevamento, in quanto prodotto comune di escrezione, ma anche da tessuti di questi, derivanti ad esempio dagli scarti di macellazione, come pelle, artigli, corni, ossa e così via. Si può migliorare ulteriormente la qualità del compost aggiungendo carbone vegetale, combustibile ottenuto dal processo di carbonificazione della legna in presenza di limitate quantità di ossigeno. Il carbone, ricco di proprietà, funge da spugna naturale per trattenere acqua e metalli pesanti,rappresenta un habitat per i microrganismi del suolo e ha potere tamponante sulle variazioni di pH che avvengono nei terreni acidi e basici. Può inoltre essere prodotto facilmente a livello industriale. L’addizione al miscuglio di cenere, prodotto finale solido della combustione della legna, ricca in sali minerali, soprattutto carbonati e ossidi, a pH fortemente basico, rappresenta un’ottima soluzione fertilizzante per tutti quei terreni di natura acida che caratterizzano la maggior parte del territorio Ciociaro. In alternativa in presenza di terreni basici, al posto della cenere, può essere utilizzata ad esempio farina di roccia di natura acida in quanto le rocce estratte per produrla sono di origine vulcanica.

Vengono stratificati questi componenti l’uno dopo l’altro fino a formare un bel cumulo di circa 1-1,5 metri di altezza ideale, e si lasciano a reagire, dopo opportuna valutazione sensoriale della quantità di acqua presente nel miscuglio di compost immaturo. Se l’acqua nel cumulo non è sufficiente, si potrebbe aggiungere persino l’acqua di vegetazione, altro importante scarto di produzione dei frantoi, la quale verrebbe prontamente degradata dai microrganismi presenti. Ciò potrebbe rappresentare una valida modalità di riciclo di questa acqua, certo non in quantità industriali, ma comunque una alternativa di uso valida dal punto di vista ecologico. Successivamente alla valutazione sensoriale della presenza di acqua, si lascia il cumulo al riparo sotto una tettoia oppure coperto da un telo per evitare che si arricchisca di acqua e quindi vada in putrefazione. Durante le prime due settimane di reazione, si monitora la temperatura del cumulo, e questa dovrebbe raggiungere una temperatura ottimale di circa 65^C entro le due settimane. In questa fase di igienizzazione, all’interno della quale tutti i batteri nocivi ad esempio quelli che promuovono la putrefazione del compost, vengono debellati dalla forte temperatura, su azione dei batteri utili, è necessario capovolgere e miscelare di continuo il cumulo per evitare che la temperatura ecceda oltre questo valore. Dopo circa 3-4 settimane di reazione, si va incontro alla fase di stabilizzazione del compost, in cui intervengono i funghi e non è più necessario miscelare il compost in quanto la temperatura sarà diminuita al di sotto dei 40^C. Si raggiunge la fase di maturazione finale dopo due mesi dalla formazione del cumulo, nella quale vengono richiamati i lombrichi, i quali vanno a colonizzare il compost ormai maturo, aumentandone la qualità.

In un terreno fortemente debilitato, povero di nutrienti, per niente fertile, si può somministrare compost maturo alla quantità di 500 quintali per ettaro per anno. Dopo circa 2-3 anni di somministrazione, dovrebbe riacquistare la fertilità, salvo altre condizioni. Una volta recuperata la fertilità del terreno, questa può essere mantenuta somministrando circa 200 quintali per ettaro per anno. Le raccomandazioni del Dottor Mancini inoltre si soffermano sul periodo di applicazione del compost tramite uno spandiletame, preferibilmente entro Gennaio-Febbraio, per piantumazioni che interessano Marzo-Aprile. Si può spandere il compost direttamente sul prato, e poi erpicarlo a poca profondità con un erpice, anche sul suolo sottostante ad un uliveto. È sconsigliato l’uso della fresa. Bisognerebbe poi innaffiare per circa 1 ora a intervalli di 3 giorni il terreno addizionato di compost, in quanto grazie alle capacità di quest’ultimo, il terreno diventa anch’esso capace di trattenere meglio l’acqua. In terreni scarsamente o per niente fertili invece si è costretti ad irrigare con grandi quantità di acqua, in quanto questi sono privi di capacità di ritenzione di questa risorsa. L’uso di compost quindi riduce la perdita di acqua, comportando sia un guadagno in termini della risorsa, sia una diminuzione dei consumi necessari ad applicarla, evitando così inutili sprechi. Ulteriori nozioni sono state fornite dal Dottor Mancini, in merito alla funzione e utilità dei sovesci con colture di copertura, come farro, veccia, trifoglio bianco, sulla, orzo, grano e di come praticarli; come eseguire un pascolamento razionale, senza evitare il sovrapascolo, come riprodurre e diffondere microrganismi utili come preparati fogliari per proteggere l’attacco dei patogeni, o come corroboranti ad azione biostimolante e potenziatrice della resistenza delle piante ai patogeni oppure come pre/pro-biotici per gli animali. Sono state fornite anche nozioni importantissime su come ottimizzare la distribuzione dell’acqua, da aree fortemente ricche, ad esempio adiacenti ad un corso d’acqua, torrente o canale di irrigazione, verso aree aride, attraverso la realizzazione delle curve di dislivello del terreno, altresì definite “disegno Keyline” o “linee a chiave”.

Per il frantoio La Ciera dei Colli e tutti i partecipanti del corso, questa esperienza sicuramente avrà acceso dei lumi di presa di coscienza, su come l’agricoltura organica rappresenti la chiave di volta del futuro, visti gli sfruttamenti agricoli a cui i terreni attuali sono sottoposti dalle monocolture, dalla concimazione chimica, dall’ eccessiva meccanizzazione dell’agricoltura, dalla riduzione del pascolamento animale e non da ultimo dall’inquinamento generalizzato della biosfera. Potrebbe diventare l’unica soluzione di miglioramento ecologico, conveniente anche dal punto di vista economico, chiudendo il ciclo produttivo

delle materie prime, che attraverso gli scarti vengono elaborate a fornire nuove materie prime, potrebbe innescare una nuova “rivoluzione agricola” a stampo ecologico, la quale ha più possibilità di successo se innescata “dal basso”, dai contadini stessi, che dovrebbero osservare con razionalità quello che la natura offre, essere in grado di sviluppare azioni più salutari per se stessi e l’ambiente che li circonda in modo da garantirne la perpetuabilità naturale, ed essere impassibili di fronte agli stimoli poco ecologici dettati dai gruppi di potere.

Dott.ssa Sara Leo